- Hochschule Trier

- Campus wählen

- Quicklinks

-

- English

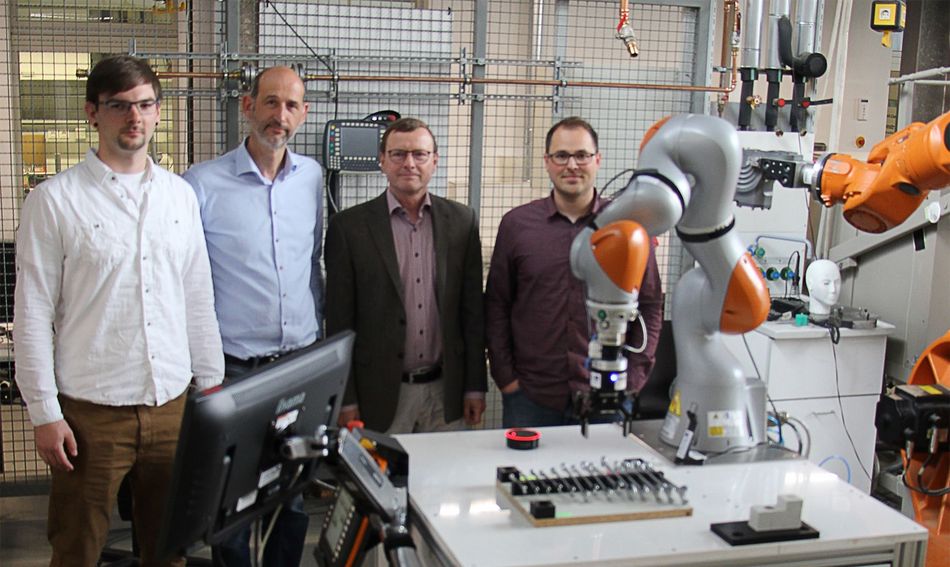

In einer interdisziplinären Projektarbeit am Institut für Softwaresysteme hat der Masterstudent Karsten Siedentopp im Bereich Wirtschaftsinformatik unter der Leitung von Prof. Rolf Krieger den Einsatz von Sprachassistenten zur Ansteuerung von Industrierobotern untersucht. Mit der Robotix-Academy am Umwelt-Campus Birkenfeld stand hierfür ein hervorragendes Umfeld bereit. Die Robotix-Academy wird an der Hochschule Trier durch Prof. Dr.-Ing. Wolfgang Gerke vertreten. Der grenzüberschreitende Forschungscluster für industrielle Robotik und Mensch-Roboter Kollaboration wird durch die Europäische Union (EFRE) im Interreg V –Programm gefördert. Mit zum Projektteam gehörte der Doktorand Jan Jungbluth, der die Kollaboration zwischen Menschen und Roboter im industriellen Umfeld an der Robotix Academy untersucht.

Die Problemstellung ist schnell beschrieben: Derzeit gibt es eine Fülle an unterschiedlichen Sprachassistenten, z.B. Alexa, Siri, Google etc. Alle diese Systeme haben eins gemeinsam, sie sollen die Mensch-Maschine-Interaktion im häuslichen Bereich vereinfachen. Eine Interaktion mittels Maus, Tastatur und Bildschirm ist oft nicht natürlich. Eine Spracheingabe ist in vielen Fällen viel naheliegender und effizienter. Dies erklärt den Erfolg der Systeme. Über einfache Befehle wie beispielsweise „Schalte das Licht im Wohnzimmer an!“ können eine Vielzahl von Haushaltsgeräten über Sprache angesteuert werden. Die Sprachassistenten bilden einen zentralen Baustein in Smart Home-Szenarien. Die spannende Frage war nun anhand eines Prototyps zu untersuchen, inwieweit über diese Assistenten auch Industrieroboter angesteuert werden können, um beispielsweise innovative Mensch-Roboter Kollaborationen unterstützen zu können.

Für die Erstellung des Prototyps wurde Alexa Echo Dot von Amazon als Sprachassistent und der Leichtbauroboter KUKA LBR iiwa ausgewählt. Der Roboter wurde von dem Unternehmen KUKA speziell für Mensch-Roboter-Kollaborationen entwickelt. Die Abkürzung iiwa steht für Intelligent Industrial Work Assistent. Ziel ist es, neuartige Produktionsprozesse zu unterstützen, in denen Menschen und Roboter in enger Zusammenarbeit hochsensible Aufgaben lösen. Zentrale Merkmale des von dem Unternehmen KUKA vertriebenen Produkts sind seine Reaktionsschnelligkeit, Feinfühligkeit und Lernfähigkeit. Er bietet die Möglichkeit komplexe Montageprozesse in einem industriellen Umfeld auszuführen.

Wesentliche Aufgabe war es nun über den Sprachassistent Alexa, der vornehmlich in Smart Home – Szenarien zum Einsatz kommt, den Roboter KUKA LBR iiwa anzusteuern. Die zentrale Frage lautete:

Wie verstehen sich Alexa und iiwa?

In der ersten Projektphase wurde das Systemumfeld von Alexa mit den dazugehörenden Komponenten analysiert. Betrachtet wurden hierbei die Funktionsweise von Alexa, das Alexa Skill Kit, Amazon Web Services (AWS), AWS Lambda und AWS IoT. In der zweiten Phase wurde dann mit Unterstützung des Doktoranden Jan Jungbluth die Ansteuerung des Roboters analysiert. Dank seiner Vorarbeiten war es möglich den Roboter über das MQTT-Protokoll mit sehr einfachen Befehlen anzusteuern. Aufgrund technischer Rahmenbedingungen ist es notwendig, die Kommunikation zwischen Alexa und iiwa über einen Raspberry Pi, einen Einplatinencomputer, zu führen. Für die Ansteuerung ist es zudem notwendig, einen digitalen Zwilling über das AWS IoT Device Management zu realisieren, der kontinuierlich den aktuellen Zustand des Roboters beschreibt.

Basierend auf diesen Erkenntnissen wurde der Prototyp umgesetzt und ein Alexa Skill entwickelt. Ein Skill stellt eine ausführbare Anwendung für den Sprachassistenten dar und bietet einem Nutzer die Möglichkeit über gesprochene Anweisungen (Intents) bestimmte Aktionen des Roboters auszuführen. Für den Prototyp wurden sechs verschiedene Anweisungen umgesetzt. Will man den Roboter in seine Grundposition bringen, genügt der gesprochene Befehl „Fahre in die Grundposition.“ Der Roboter bewegt sich aus der augenblicklichen Position in seine Grundposition und wartet auf weitere Befehle. Ein etwas komplexerer Sprachbefehl ist die Anweisung, über die der Roboter einen Schraubenschlüssel reichen soll. Die Anweisung lautet hierzu „Gib mir einen 18’er Schraubenschlüssel.“ Der Roboter greift dann nach dem spezifizierten (18’er) Schlüssel und reicht diesen dem Nutzer. Weitere Anweisungen beziehen sich auf die Positionierung des Roboterarms, das Öffnen des Greifers oder das Abfragen von Statusinformationen. Über das Projekt wurden Schwächen und Stärken der Sprachassistenten in einem industriellen Umfeld identifiziert. Das Potenzial der Sprachassistenten wurde deutlich. So kann der Mensch in kollaborativen Arbeitsprozessen dem Roboter Anweisungen geben und mit seinen Händen weiter Montagearbeiten ausführen. Das Projekt hat aber auch gezeigt, wie wichtig die interdisziplinäre Zusammenarbeit von Maschinenbau und Informatik in Digitalisierungsprojekten im industriellen Umfeld ist.

Sie verlassen die offizielle Website der Hochschule Trier